Tijdens Advancing AI 2025 te San Jose is AMD er stellig over: Nvidia is te verslaan en heeft geen ‘moat’. Snellere Instinct-GPU’s, schaalbare networking, een volwaardige AI-rackoplossing en een strakgestreken roadmap wekken vertrouwen.

Het sinds 2016 bewandelde pad van AMD is inmiddels bekend. Nadat het op de rand van de financiële afgrond stond, wist het Intel op prijs, prestaties en executie te verslaan op CPU-gebied. Inmiddels wemelt het van de Ryzen-chips in desktops en laptops en Epyc-processoren in professionele omgevingen. Aan de GPU-zijde is er een lastigere uitdaging te vinden. Nvidia, de “wereldkampioen AI” om het even plat te slaan, is lang niet zo kwetsbaar als Intel was en nog altijd is.

We bespreken in dit artikel zowel de AI-gerichte hardware als software van AMD. Dankzij een bijzonder uitgebreide uitleg weten we al heel veel over het aanbod in 2026-27, met weinig noodzaak voor creatief vermogen om te bedenken wat er daarna volgt. Als alles goed gaat, is AMD net zo voorspelbaar bezig als het metronomische TSMC waar haar chips gefabriceerd worden.

Instinct MI350 nu, MI400 later

We wisten in oktober vorig jaar al dat Instinct MI350 de voornaamste AMD-GPU voor enterprise AI zou worden. Begin juni is de productie ook echt van start gegaan, met de eerste leveringen in Q3. De grootste inkopers zijn de hyperscalers, AI-specialisten en “neo clouds”, ofwel de GPU-gefocuste cloudspelers. Andrew Dieckmann, CVP en GM Data Center GPU Business, ziet dat het wel goed zit qua adoptie. Zeven op de tien grootste AI-partijen gebruiken AMD Instinct “op schaal”.

De nadruk ligt op vier aspecten bij AMD’s huidige Instinct-aanbod. Alleereerst moeten de prestaties gelijkwaardig zijn aan Nvidia of deze overtreffen. De TCO dient daarnaast lager te zijn, een essentieel punt om klanten te werven als ze de vrije keuze hebben tussen Nvidia en AMD. Ook moet migratie eenvoudig zijn, draait zoveel mogelijk op een open(-source) basis en moet de klant centraal staan.

Dat laatste klinkt als typische marketingpraat, maar er wordt wel degelijk geluisterd naar recente wensen. Zo toont CEO Lisa Su tijdens haar presentatie dat er van Oostenrijk tot Singapore soevereine AI-initiatieven op basis van AMD worden uitgebouwd.

In de nabije toekomst staat MI350 centraal als alternatief voor Nvidia’s Blackwell-architectuur, met naast lagere kosten een focus op eenvoudige implementatie. Denk daarbij aan opties voor zowel luchtkoeling als liquid cooling, ook al stelt Dieckmann dat de stap naar liquid een kantelpunt heeft bereikt dit jaar. AMD zal luchtgekoelde opties blijven leveren, maar in de toekomst moeten klanten nu eenmaal hun datacenters op de schop nemen of nieuwe locaties bouwen met liquid-first als filosofie.

In 2026 zal MI400 volgen, dat bizar genoeg al van allerlei benchmarks voorzien is tegenover het de zo fictieve Vera Rubin-GPU van Nvidia. AMD belooft ergens tussen de “1x en 1,3x” prestaties. We zullen het zien.

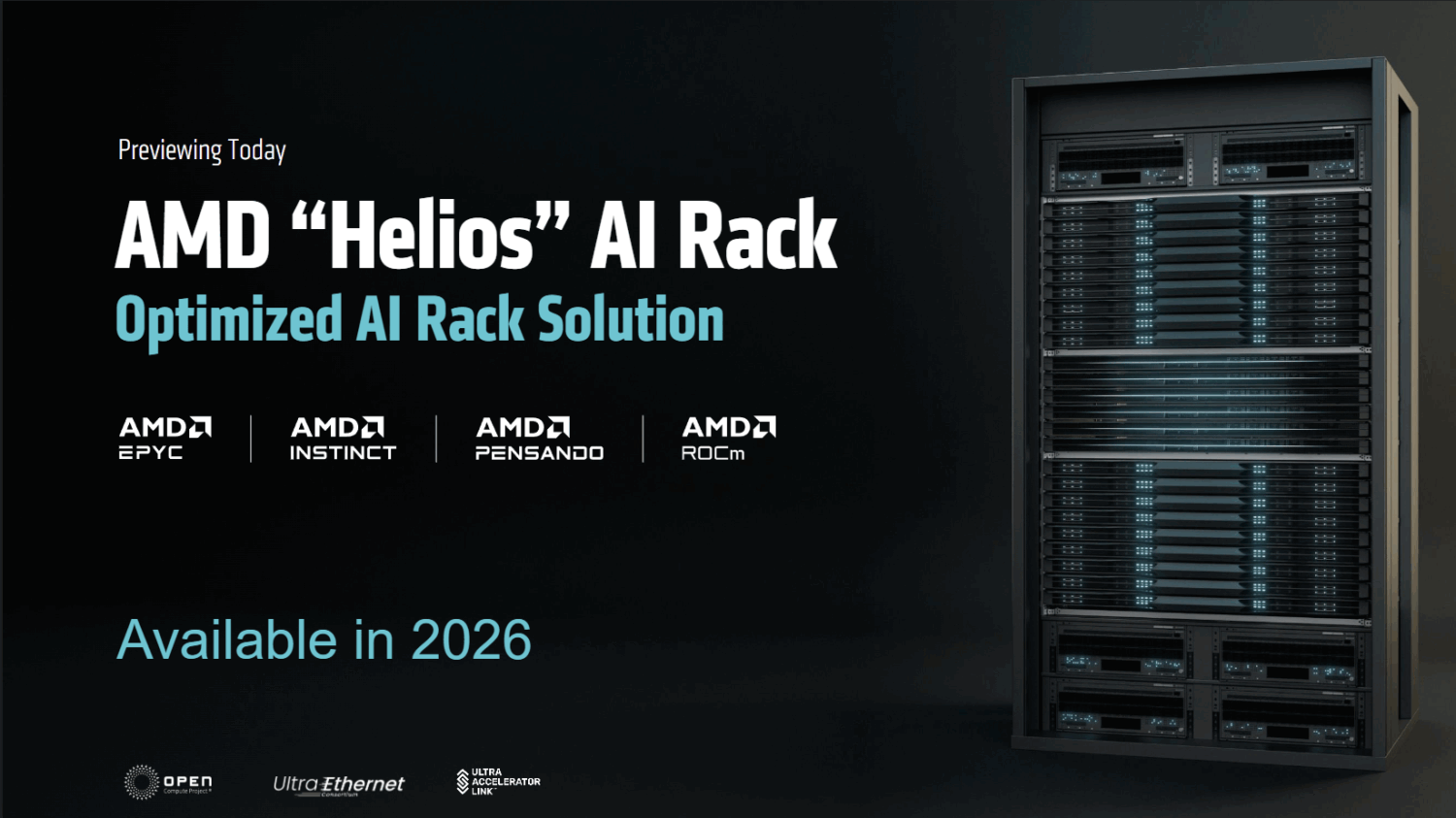

Echt Nvidia-achtig: de Helios AI Rack

Vorig jaar werd duidelijk dat AMD het gemunt had op het netwerk. Voor enterprise AI-workloads is het netwerk cruciaal om elke GPU te voorzien van de data die het nodig heeft, iets dat bij het geregeld falen ervan tot wel 10 procent aan vertraging kan oplopen (zoals Meta ontdekte). Packets kunnen anno 2025 niet meer af en toe verloren gaan.

De reden dat dit AMD veel aangaat, is omdat het eigenlijk meer wil aanbieden dan “alleen” Epyc-CPU’s en Instinct-GPU’s. Natuurlijk bouwt het ook NIC’s en DPU’s, maar we moeten een stap ambitieuzer denken. Nvidia levert bijvoorbeeld wat het weleens “AI-dozen” of “plug-and-play AI” noemt. Dit zijn peperdure DGX GB200-systemen die door de hyperscalers en allergrootste AI-spelers met elkaar worden verbonden voor massale training en inferencing. Nvidia doet dit met InfiniBand, een proprietary oplossing, terwijl AMD samen met haar Ultra Ethernet Consortium-collega’s voortborduurt op de welbekende Ethernet-standaard.

Daarbij wil AMD ondanks de open standaarden het liefst een rackscale oplossing leveren. Deze moet wel binnen de filosofie passen en dus OCP-compliant zijn voor directe datacenter-inzet. Dat gaat in 2026 ook eindelijk gebeuren in de vorm van de AMD “Helios” AI Rack. Dit combineert Epyc, Instinct, Pensando en de ROCm-softwarestack voor een zo eenvoudig en grootschalig mogelijke AI-deployment.

De specificaties zijn gerust astronomisch te noemen. 72 Instinct MI400 (met elk 432GB aan HBM4-geheugen, aanzienlijk meer dan de 288GB in MI350) leveren 31 TB aan VRAM en 1,4 PB/s aan geheugenbandbreedte. Dat is respectievelijk 1,5x zoveel capaciteit en bandbreedte als Vera Rubin. Het vertegenwoordigt een snellere evolutie van de Instinct-lijn dan eerdere releases suggereerden, met een “hockeystick” op de grafiek op het gebied van AI-prestaties tot gevolg.

Je zou bijna Epyc vergeten, maar ook de CPU blijft een kritiek component voor Helios. Epyc “Venice” is de codenaam voor de op Zen 6 gebaseerde processor in deze AI Rack. AMD belooft een verdubbeling van de bandbreedte tussen CPU en GPU, 70 procent hogere CPU-prestaties en een geheugenbandbreedte van 1,6 TB/s.

Het is de software

Hoe imposant het hardware-verhaal ook is, de achilleshiel van AMD is momenteel de software. Terwijl Nvidia haar 90 procent enterprise AI-marktaandeel verdedigt met de proprietary CUDA-softwarestack, daagt AMD het uit met het open-source ROCm-project. Meer partnerships, zoals met PyTorch, Triton en Hugging Face, moeten day-0 support opleveren voor alle nieuwe AI-modellen.

ROCm 7 en met name het nieuwe ROCm Enterprise AI doen er een schepje bovenop. Cluster management moet hoofdpijndossiers wegnemen voor massale AMD-uitbouw. Ramine Roane, CVP AI Solutions Group, stelt dat de ingebouwde observability en deployment-opties weken aan werk wegnemen en downtime voorkomen.

Daarnaast is ROCm nu lokaal te draaien op volledig AMD-gedreven desktops en laptops. Dit was voorheen een pijnlijk punt voor AMD, geeft Roane toe; Nvidia-gebruikers konden CUDA op hun niet al te imposante notebook gebruiken bijvoorbeeld. Een andere toevoeging is support voor Windows, dat tevens lang een probleem is geweest voor ROCm-adoptie.

Een ietwat penibel punt is het feit dat ROCm de prestaties van bestaande AI-hardware enorm verbetert. Zo draait DeepSeek-R1 in ROCm 7 bijna vier keer zo snel op dezelfde Instinct MI300 als binnen ROCm 6. Perfect, zou je zeggen, maar dit wijst erop dat er echt ontzettend veel rek zat in de hardware (en wellicht nog altijd zit). Aangezien de grootste AMD-klanten elk jaar upgraden in deze “abrupte” GPU-verversingscyclus, moet je je afvragen hoeveel prestatie er verloren gaat elk jaar. Desondanks is de verbetering er en wordt ROCm elke twee weken voorzien van nieuwe updates.

Daarnaast wordt een AMD Developer Cloud gelanceerd, waarbij ontwikkelaars toegang krijgen tot een dag aan gratis AI-hardwaregebruik. Enkel een login via GitHub is vereist. AMD wil ROCm naar eigen zeggen overal brengen, waarbij dit charmeoffensief een belangrijke stap betekent.

Nvidia heeft geen ‘moat’

Verreweg de meest opvallende uitspraak van AMD’s Advancing AI-evenement komt vanuit Ramine Roane. Hij legt uit dat Nvidia helemaal geen “moat” heeft, ofwel een ingebouwd voordeel dat uitdagers van CUDA niet zomaar overbruggen. Hij legt uit dat er elke twee jaar weer totaal nieuwe GPU-kernels geschreven moeten worden, dat het speelveld weer gelijktrekt.

Dit draait niet om de functionele support van een GPU, maar om de fundamentele architectuur van de chip. Voor de leek op hardware-gebied: de reden dat GPU’s zoveel sneller AI berekenen dan CPU’s is dat de vereiste berekeningen veel sneller door een relatief eenvoudig opgezette GPU-chip gaan dan door de complexe CPU-core. Matrixvermenigvuldigingen, het fundament voor LLM-calculaties, lijken qua structuur simpelweg meer op de fysieke ontwerpen van GPU-acceleratie.

Echter moeten deze ontwerpen telkens ietsje worden aangepast. Dit is omdat er andere dataformats worden gebruikt om prestaties te verbeteren. De nadruk komt daarbij te liggen op andersoortige berekeningen die weliswaar lijken op de vorige, maar toch een andere achitectuur vereisen voor optimale prestaties.

Met andere woorden: nieuwe GPU-generaties voor AI draaien dus slechts gedeeltelijk om de efficiëntiewinst en de snellere berekeningen door kleinere chipprocessen. Dat laatste ontstaat dus ook door chips te bouwen die de vereiste berekeningen beter reflecteren. Daarbovenop moet AMD net als Nvidia de software uitbouwen en optimaliseren.

Conclusie: een sterk verhaal, maar wat brengt de praktijk?

We denken dat de AMD-strategie van prestaties in de buurt van Nvidia voor een lagere prijs logisch is. De sleutel naar succes is de open aard van de AI-stack, waarbij partners als Cisco, Juniper en HPE bijdragen aan innovatie zonder een gesloten domein af te dwingen bij klanten.

Echter is de dominantie van Nvidia onmiskenbaar. Toen we AMD eraan herinnerden dat de huidige schattingen Nvidia op 90 procent marktaandeel in deze sector plaatsen, knikte men mee. Alleen als dat getal verandert, is de wurggreep van Nvidia duidelijk aan het afnemen. AMD heeft hoe dan ook verreweg de beste papieren. Intel, Cerebras, Groq, noem ze maar op, ze komen niet eens in het verhaal voor.

Lees ook: AMD’s nieuwste doelwit binnen datacenters: het netwerk

English (US) ·

English (US) ·